作者:finedatalink

发布时间:2023.8.11

阅读次数:1,175 次浏览

在当今数字化时代,数据集成成为了企业实现高效决策和创新的关键。Apache Kafka、Apache NiFi和Talend作为领先的数据集成工具,各自拥有独特的功能和特点,本文将深入比较这三款工具,帮助您了解它们的优势和适用场景,为您在数据集成工具选择时提供有力的指导。

Apache Kafka作为一个开源的实时流处理平台,专注于大规模数据流的处理和分发。它的功能和特点包括:

1、高吞吐量: Apache Kafka设计用于处理大量数据流,支持高吞吐量的消息传递,适用于需要处理海量数据的场景。

2、持久性存储: Kafka将数据持久地存储在磁盘上,保证数据不会丢失,适合需要可靠性和数据安全的应用。

3、实时性: Kafka支持实时数据处理,能够处理和传输实时生成的数据,使其适用于实时分析和决策场景。

4、分布式架构: Kafka的分布式架构使其能够处理大规模数据,具备高可用性和容错性。

Apache NiFi是一个可视化的数据流工具,旨在简化数据流程的设计和管理。它的功能和特点包括:

1、可视化界面: NiFi提供了直观的可视化界面,允许用户通过拖放操作来构建和管理数据流程,降低了技术门槛。

2、数据整合: NiFi支持多种数据源和目标的整合,使其适用于复杂的多源数据集成场景。

3、数据安全: NiFi提供了数据加密、认证和授权等安全功能,保护数据在传输过程中的安全性。

4、数据转换和处理: NiFi支持数据的转换和处理,可以实时对数据进行清洗、转换和过滤。

Talend是一款全面的数据集成平台,涵盖了数据整合、转换、清洗等多个方面。它的功能和特点包括:

1、广泛的连接器: Talend提供了丰富的连接器,支持多种数据源和目标的集成,满足了不同数据集成需求。

2、数据质量管理: Talend内置了数据质量管理功能,帮助用户识别和纠正数据质量问题,保障数据的准确性。

3、ETL处理: Talend支持ETL(提取、转换、加载)处理,能够将数据从源抽取、进行转换处理,并加载到目标系统。

4、开发和部署: Talend提供了开发和部署工具,帮助用户轻松构建和管理数据集成作业。

在选择合适的数据集成工具时,需要根据项目需求和特点进行综合考虑。如果您需要处理大规模实时数据流,Apache Kafka可能是更好的选择。如果您希望通过可视化界面来构建和管理数据流程,Apache NiFi可能更适合您。而如果您需要一个全面的数据集成平台,能够处理多种数据源和目标,同时具备数据质量管理等功能,Talend可能是更合适的选项。

Apache Kafka、Apache NiFi和Talend作为数据集成领域的佼佼者,都各自展现了强大的功能和特点。然而,如果您寻求一个全面的、高效的数据集成解决方案,FineDataLink也值得您的关注。

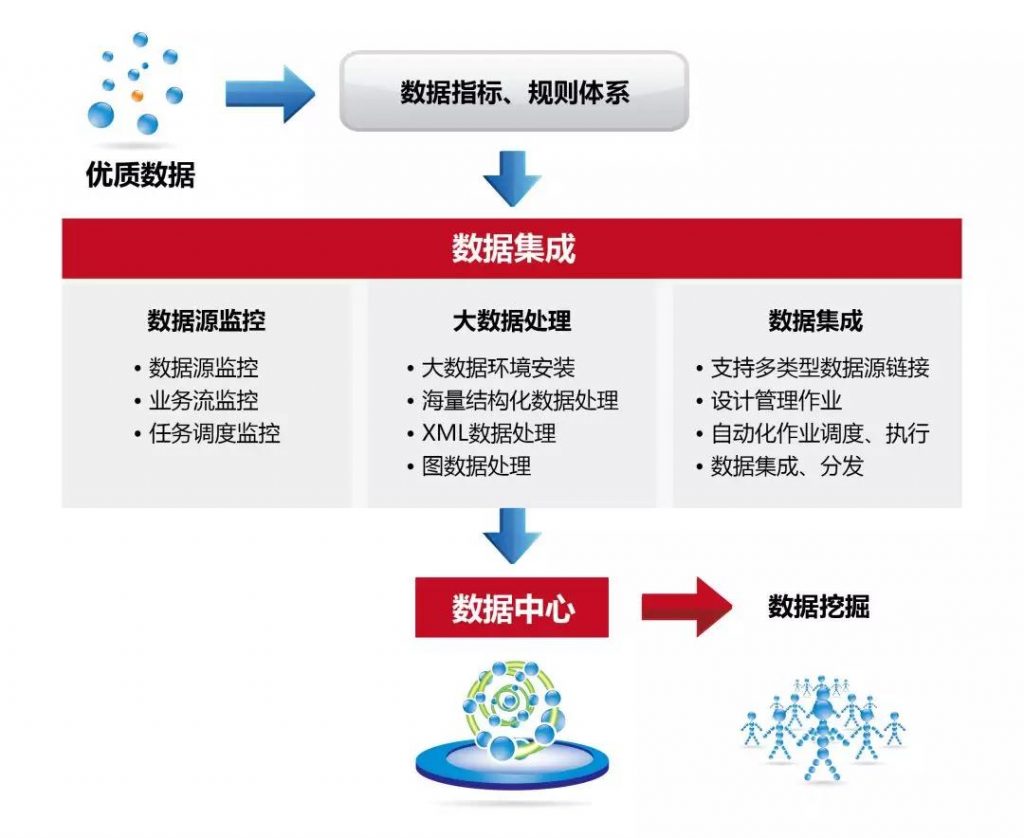

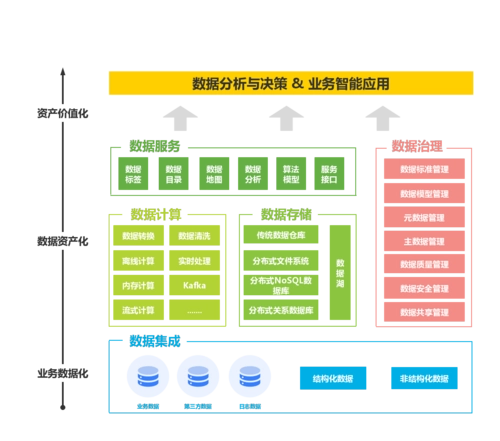

作为一款领先的数据集成工具,FineDataLink在多方面提供了卓越的能力,满足了不同项目的需求:

1、灵活的数据流程设计: FineDataLink提供了直观易用的可视化界面,帮助用户轻松构建和管理数据流程,实现数据源到目标的无缝集成。

2、数据质量管理: FineDataLink内置了强大的数据质量管理功能,帮助用户自动识别和纠正重复、缺失和错误数据,确保数据的准确性和完整性。

3、广泛的连接器: FineDataLink支持多种数据源和目标的连接,能够轻松集成不同系统之间的数据流动。

4、实时性与性能: FineDataLink通过分布式系统的支持,实现了高吞吐量和低延迟的数据传输,适应了实时性要求较高的场景。

5、数据安全保障: FineDataLink提供了数据加密、认证和授权等安全功能,确保数据在传输过程中的安全性。

在选择数据集成工具时,FineDataLink不仅满足了数据流程设计的需求,还在数据质量管理、连接性、性能和安全性等方面提供了全面的支持。无论您是处理大规模数据流、实时数据集成,还是寻求高质量的数据质量管理,FineDataLink都能够助您一臂之力。借助FineDataLink,您可以更加自信地面对复杂的数据集成挑战,实现更高效、准确的数据流动,为企业的决策和业务发展提供强大支持。

数据集成平台产品更多介绍:www.finedatalink.com