作者:finedatalink

发布时间:2023.8.21

阅读次数:362 次浏览

在当今这个信息爆炸的时代,数据已经成为了企业和个人的重要资产。随着大数据技术的不断发展,越来越多的企业和个人开始关注如何有效地处理和管理这些海量的数据。数据管道作为一种强大的数据处理工具,可以帮助我们更好地应对这一挑战。本文将详细介绍如何通过数据管道进行大规模的数据处理。

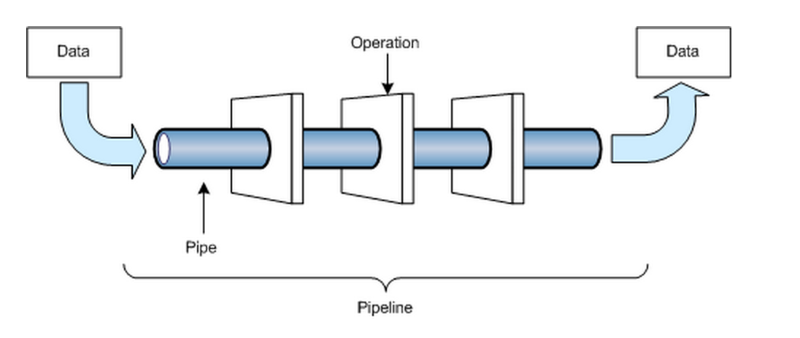

数据管道是一种用于传输、存储和管理数据的系统,它可以帮助我们更高效地处理和管理数据。数据管道通常包括三个主要部分:输入端、处理端和输出端。输入端负责从各种数据源收集数据,处理端负责对数据进行处理和转换,输出端负责将处理后的数据发送到目标系统或存储位置。通过这三个部分的协同工作,数据管道可以帮助我们实现对数据的自动化处理和管理。

传统的数据处理方法通常需要人工进行数据清洗、转换和整合等操作,这不仅耗时耗力,而且容易出错。而数据管道通过自动化的方式处理数据,可以大大提高数据处理的效率。此外,数据管道还可以根据需求自动调整数据处理流程,以满足不同场景下的数据处理需求。

采用传统的数据处理方法,企业和个人需要投入大量的人力和物力来维护和优化数据处理流程。而数据管道可以实现对数据处理过程的自动化管理,从而降低数据处理的成本。通过数据管道,企业和个人可以将更多的精力投入到核心业务上,从而提高整体的运营效率。

数据管道采用严格的数据处理逻辑和标准化的数据处理流程,可以确保数据处理的准确性和一致性。此外,数据管道还可以实时监控数据处理过程中的错误和异常,及时发现并解决问题,从而提高数据处理的质量。

在进行大规模数据处理之前,首先需要确定数据的来源。数据来源可以包括数据库、文件系统、API接口等多种类型。在选择数据源时,需要考虑数据的实时性、完整性和可用性等因素,以确保数据管道能够高效地处理数据。

设计合理的数据处理流程是构建一个高效的数据管道的关键。在设计数据处理流程时,需要考虑到数据处理的目的、数据的类型和格式、处理的复杂度等因素。通过对这些因素的分析,可以确定数据处理的顺序和方法,从而确保数据处理的正确性和高效性。

在进行大规模数据处理时,选择合适的数据处理工具和技术是非常重要的。目前市面上有很多优秀的数据处理工具和技术,如Apache Hadoop、Apache Spark、Apache Flink等。在选择工具和技术时,需要考虑到工具和技术的性能、稳定性、易用性等因素,以确保数据管道能够顺利地处理数据。

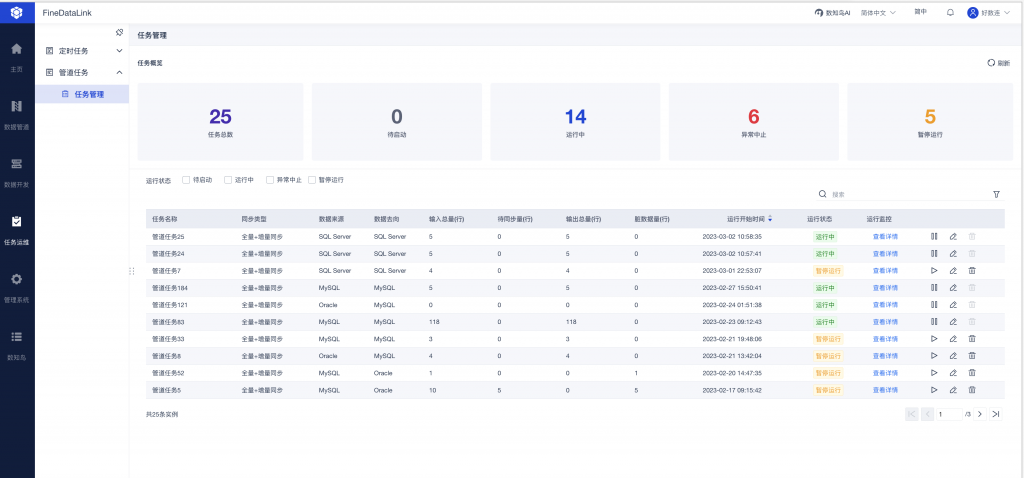

在构建了一个高效的数据管道之后,还需要对其进行持续的监控和优化。通过监控数据管道的运行状况,可以及时发现并解决潜在的问题,从而确保数据管道的稳定运行。此外,通过对数据管道的运行情况进行分析和优化,可以进一步提高数据处理的效率和质量。

总之,通过数据管道进行大规模数据处理是一种非常有效的方法。通过选择合适的数据源、设计合理的数据处理流程、选择合适的数据处理工具和技术以及实施数据管道监控和优化,我们可以构建一个高效的数据管道,从而更好地应对大数据时代的挑战。

在实现这些目标的过程中,FineDataLink将为您提供强大的支持。FineDataLink致力于为企业提供一站式的数据集成、数据治理和数据分析解决方案,帮助企业实现数据的快速流通、高效利用和价值发现。通过使用FineDataLink的智能数据管理平台,您可以拥有可靠的数据管道和数据流系统,实现数据的实时监控、质量控制和安全防护,助力企业实现数字化转型的目标。

数据集成平台产品更多介绍:www.finedatalink.com

上一篇: 数据管道和数据流在人工智能中的应用下一篇: 数据管道和数据流的未来发展趋势