作者:finedatalink

发布时间:2023.8.7

阅读次数:338 次浏览

在当今信息爆炸的时代,企业和组织面临着大量数据的涌入和积累。高效地处理大规模数据变得至关重要,这不仅有助于获取有价值的见解,还能为业务决策提供有力支持。本文将介绍一些数据处理的窍门,在面对大规模数据时保持高效。

在开始处理大规模数据之前,确保您明确了处理的目标和需求。了解您希望从数据中获得什么信息,以及这些信息将如何支持您的业务决策。这将有助于指导数据处理的方向和方法。

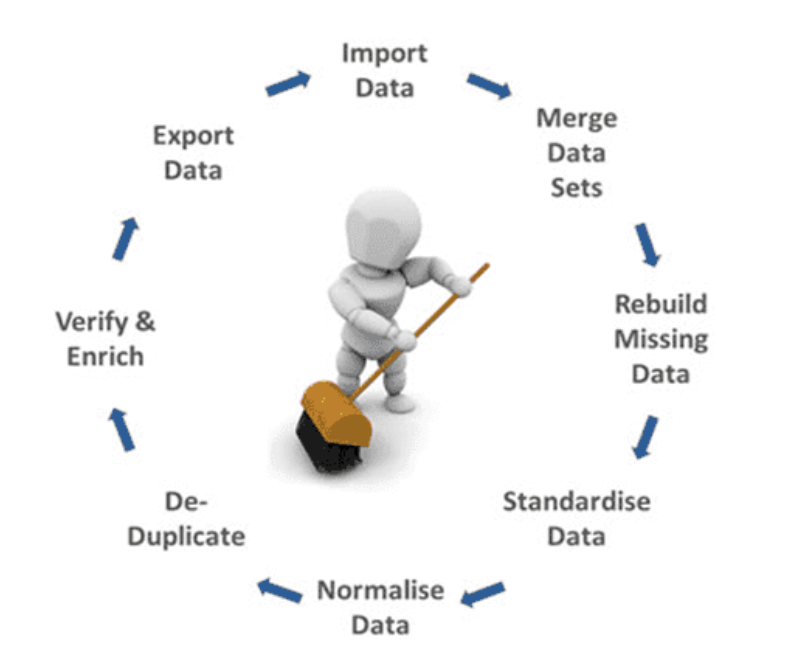

制定详细的数据分析计划,包括数据的收集、清洗、转换、分析和可视化等步骤。确保每个阶段都得到适当的规划和资源分配,从而高效地进行数据处理。

根据数据处理的需求,选择适合的工具和技术。对于大规模数据处理,可能需要考虑使用分布式计算技术,如Hadoop和Spark,以加速处理速度。

将数据分为较小的批次进行处理,利用并行处理的能力来提高处理效率。分批处理可以减少单个任务的复杂性,更好地利用计算资源。

在进行数据分析之前,进行数据预处理和清洗是至关重要的一步。去除重复值、处理缺失数据、标准化数据格式等可以减少后续处理过程中的问题。

优化数据存储可以提高数据访问速度和处理效率。选择适当的数据库系统、索引和分区策略,以确保数据在存储和检索过程中高效。

利用并行算法和多核处理技术,将任务分解成多个子任务并同时处理,从而提高处理速度。这对于处理复杂的数据分析和计算特别有效。

在进行数据分析之前,预先计算和聚合一些数据指标,可以减少后续计算的复杂性。这样可以在处理过程中节省时间和计算资源。

将处理后的数据通过可视化工具展示出来,可以更直观地理解数据的趋势和模式。有效的数据报告可以帮助您更快地做出决策。

数据处理是一个持续优化和改进的过程。定期审查数据处理流程,寻找优化的机会,并根据实际情况进行调整和改进。

高效地处理大规模数据是现代企业成功的关键之一。通过明确的处理目标、合适的工具和技术、并行处理策略以及持续的优化,您可以在处理大规模数据时保持高效,从而为业务决策提供更准确和及时的支持。将这些数据处理窍门纳入您的数据分析计划中,将有助于您最大程度地发掘数据的价值。

使用数据集成工具FineDataLink,可以转化不统一或质量低的数据,还可以将数据清洗和处理集中完成,将数据整合到数据仓库,减少数据连接和错误重试等繁琐的开发时间。通过任务级别的结果通知,配合任务概览,对最近报错、异常中断的任务,查看详情进行修正处理,以保证所有任务的正常运行。

数据集成平台产品更多介绍:www.finedatalink.com