作者:finedatalink

发布时间:2023.8.17

阅读次数:609 次浏览

在当今互联网时代,数据的持续增长和多样化给企业带来了巨大的挑战和机遇。数据集成作为数据处理的重要环节,对于企业来说显得尤为重要。传统的数据集成方式往往面临着实时性不高、数据一致性难以保证等问题。然而,流批一体引擎的出现为解决这些问题提供了新的途径。

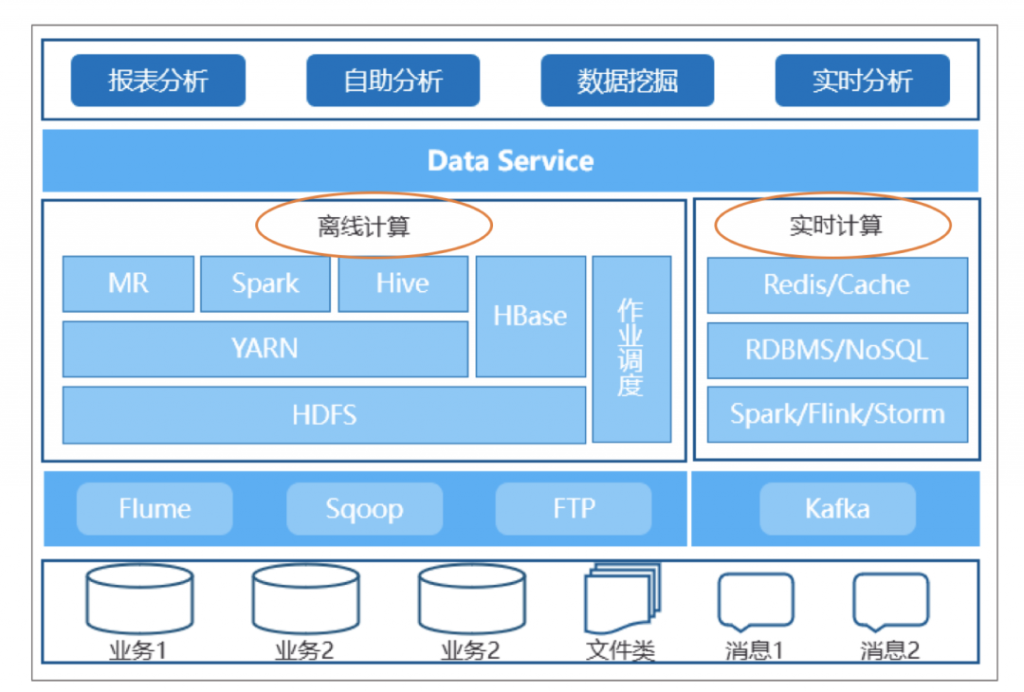

流批一体引擎是一种将流处理和批处理相结合的数据处理引擎。它能够同时处理实时数据流和离线批量数据,并实现数据的实时采集、处理和存储。

流批一体引擎通常由三个组件组成:数据采集模块、数据处理模块和数据存储模块。

流批一体引擎能够在数据到达时立即进行处理,实现数据的实时采集和实时处理。相比传统的批处理方式,流批一体引擎具有更高的实时性,能够更快地响应数据的变化。

流批一体引擎在数据处理过程中采用了事务机制,能够保证数据的一致性。在数据采集过程中,如果发生错误,流批一体引擎会自动回滚操作,确保数据的一致性。

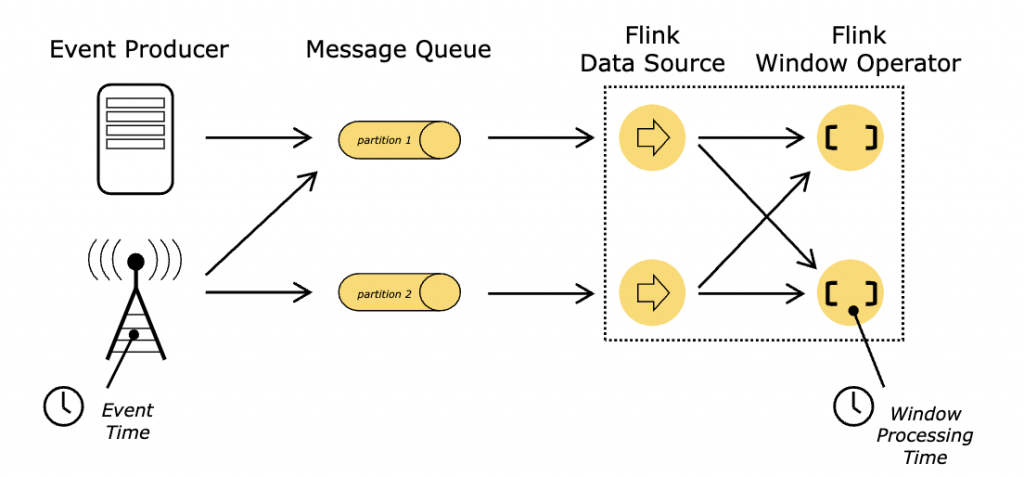

流批一体引擎采用并行处理的方式,能够同时处理多个数据流和批量数据。它能够根据数据的特点和需求进行动态调整,从而提高数据处理的效率和质量。

流批一体引擎的数据处理模块采用了模块化的设计,能够根据需要进行扩展。企业可以按需增加新的数据处理模块,从而满足不断增长的数据处理需求。

流批一体引擎能够实时采集和处理数据,适用于实时数据集成场景。例如,电商网站可以通过流批一体引擎实时采集用户行为数据,并根据用户的喜好推荐相应的商品。

流批一体引擎可以处理大规模的离线批量数据,适用于批量数据集成场景。例如,金融机构可以通过流批一体引擎将多个系统的交易数据进行集成,实现全面的数据分析和风险控制。

在数据集成过程中,常常会出现数据丢失的情况。流批一体引擎通过采用容错机制和数据回滚机制,能够有效避免数据丢失问题的发生。

数据一致性是数据集成中一个非常重要的问题。流批一体引擎通过事务机制和幂等性处理,能够保证数据一致性。

传统的数据集成方式往往处理效率低下。流批一体引擎通过并行处理和动态调整策略,能够提高数据处理的效率,减少处理时间。

流批一体引擎作为一种新的数据处理引擎,在数据集成中发挥着重要的作用。它能够快速实现实时数据的采集、处理和存储,提高数据集成的效率和可靠性。在未来,随着数据规模的不断增长,流批一体引擎将会得到更广泛的应用。

越来越多的业务需要更高的时效性。数据集成工具FineDataLink提供的方案是,通过数据库日志解析等能力,实现了批量表的实时同步,并且支持表结构变更同步、断点续传等,最后实现流批一体。

数据集成平台产品更多介绍:www.finedatalink.com