作者:finedatalink

发布时间:2023.9.6

阅读次数:868 次浏览

ETL工具是用于数据抽取、转换和加载的工具,它能够从各种数据源中抽取数据,然后进行清洗、整合和转换,最后将数据加载到目标系统中,以便进行分析、决策和预测。常见的ETL工具包括Kettle、Informatica、Datastage、FineDataLink等。

kettle的组件很多,功能很强大,也支持开源,百度、csdn上的学习内容很多,在kettle之前,很多人都会用python去进行数据处理,的确python可以解决很多问题,但学习成本更高。kettle的话,只需要你知道SQL怎么写,在定时批量常见下,能够很好地处理离线数据,一般情况下处理T+1的场景是没什么问题的。

但缺陷就是,kettle 的定时调度,任务过多时,你只能通过 系统自带的 定时任务调度 去进行管理,写日志。无法做到统一的管理,假如要做统一的管理也行,安装一套jenkins,但配置和后续的运维成本可能较高。

以及kettle的内存占用较高,无法最大效率地利用服务器资源。

批量定时用kettle下也是没问题的,假如说要做到实时场景下的数据同步处理,那可能就要找找其他工具了,毕竟数据实时是企业数据发挥价值的重要武器。

实时的ETL工具,目前都是收费的。

Informatica 是商业软件,没有开源版本。

Informatica 是一款优秀的商业产品,其基于数据集成主线,扩展出一系列满足数据准备、数据管理需求的产品和解决方案,产品矩阵高度满足企业数据化建设的需求场景,是数据集成、数据管理领域的领军产品。

在Gartner的评分中综合评分和细分维度的评分绝大部分都处于较高的值,假如是外国的土豪公司,可以好不犹豫地选择Informatica。

中国区域的客户还是有一些大客户的,但是我这边在调研的时候发现其中文官网多个入口出现404且申请使用的页面无法响应,主观上感觉其在中文区的投入可能比较小。

IBM DataStage能够帮助企业从散布在各个系统中的复杂异构信息获得更多价值。DataStage 提供的统一的平台, 使公司能够了解、清理、变换和交付值得信赖且上下文丰富的信息。

非常专业的ETL工具,但价格昂贵。

集“实时数据同步”和“离线数据处理”于一体的数据集成平台,可对接数据库、上层通用协议、消息队列、文件、平台系统、应用等类型的数据源,支持数据服务的API接口发布,同时数据处理界面友好美观,有统一的运维平台,是一款本土化自研数据集成产品。

除了kettle的定时数据处理场景,还能对接多种数据库,基于CDC、logminer、binlog等进行数据的实时同步。

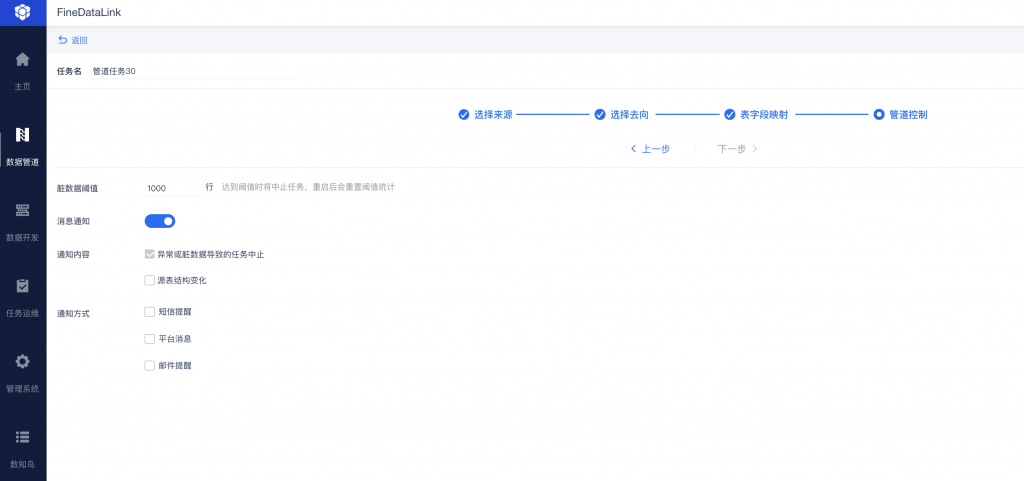

BS端的方式,让你随时随地可以进行数据的处理方便,方便看到各个任务的运行状态,当任务出现问题时,还可以进行统一的消息通知,比如邮件、企业微信等。数据准确的重要保障是,数据处理任务是否正常运行就是至关重要的,以及任务出错时的重启机制。除此之外,FDL还有服务器内存、磁盘、IO等的监控,为任务正常多了一层保障。

搭配中国复杂式报表FR+自主分析平台BI,可以很好地将数据进行集成、处理、存储、分析试用和分享,让数据成为生产力,让企业数据得到更大价值的发挥。

FineDataLink是一款低代码/高时效的数据集成平台,它不仅提供了数据清理和数据分析的功能,还能够将清理后的数据快速应用到其他应用程序中。FineDataLink的功能非常强大,可以轻松地连接多种数据源,包括数据库、文件、云存储等,而且支持大数据量。此外,FineDataLink还支持高级数据处理功能,例如数据转换、数据过滤、数据重构、数据集合等。使用FineDataLink可以显著提高团队协作效率,减少数据连接和输出的繁琐步骤,使整个数据处理流程更加高效和便捷。

数据集成平台产品更多介绍:www.finedatalink.com

上一篇: 实时数据同步:工业4.0智能制造的实时数据采集和处理技术下一篇: 在终端执行kettle的作业任务,为什么终端关闭了,这个作业任务也会关闭?