作者:finedatalink

发布时间:2023.8.22

阅读次数:297 次浏览

在当今数字化时代,数据对企业决策和创新至关重要。数据集成工具在实现不同数据源、系统之间的连接和交换时起着核心作用。然而,保障数据的高可用性与高并发性能是数据集成中的一大挑战。本文将深入研究如何在数据集成中实现稳定的高性能,确保数据的准确传输与高效处理。

高可用性,作为数据集成的基石,意味着系统在面临硬件故障、网络问题或其他异常情况时,仍然能够提供服务,保障数据流程的持续性。

高并发性能在数据集成中至关重要,尤其是在面对大量数据同时输入或输出的情况下。高并发性能的实现能够确保数据传输的实时性与高效性,有效应对数据量剧增的挑战。

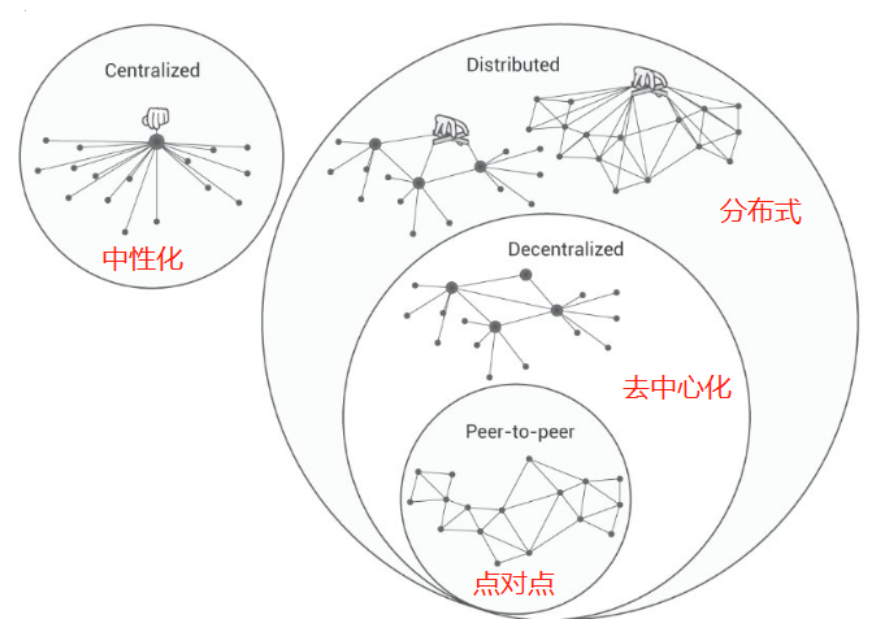

去中心化微服务集群是确保高可用性的关键策略。通过将任务分解为多个微小服务单元,系统能够在某个服务发生故障时,依然保持其他服务的正常运行,实现无缝切换与快速恢复。

通过实施动态扩展策略,系统能够根据需求自动调整资源,以适应不同负载情况。结合负载均衡技术,数据集成工具能够将任务均匀分配到各个服务单元,保障每个服务的稳定性,提高整体系统的可用性。

采用多线程处理和异步机制能够有效提升数据处理速度,使数据能够同时被多个线程处理,加速数据集成过程。此外,适当的线程管理与资源调度能够避免性能瓶颈,确保系统在高并发情况下的稳定性。

数据缓存与预取技术能够在高并发场景下减轻数据库负担,降低数据读取频率。通过将常用数据预先加载到内存中,可以快速响应用户请求,提高数据处理效率。

数据集成中的高可用性与高并发性能是确保数据流畅运行的关键因素。通过构建去中心化微服务集群、动态扩展、负载均衡、多线程处理和数据缓存等策略,可以有效提升系统的稳定性与性能,确保数据的高效传输与处理,助力企业实现基于数据的创新与发展。

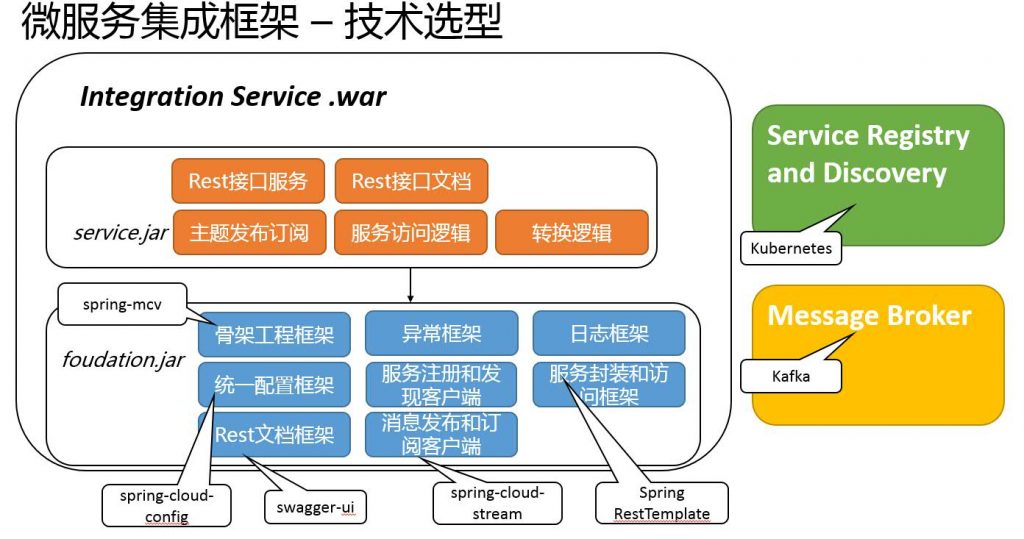

FineDataLink是一款低代码/高效率的ETL工具,同时也是一款数据集成工具,它可以帮助企业提高数据治理效率和质量。FineDataLink满足了去中心化微服务集群,能同时满足高可用、高并发等要求,并支持各模块微服务部署、动态扩缩、故障迁移、自定义负载均衡、任务容错与重试等各类场景。

数据集成平台产品更多介绍:www.finedatalink.com