作者:finedatalink

发布时间:2024.8.9

阅读次数:150 次浏览

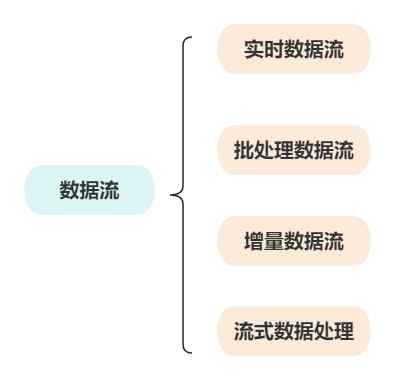

在数字化时代,数据成为推动业务发展的核心资产。有效地管理和处理数据流,对于企业实现数据驱动决策至关重要。本文将探讨数据流的基本概念、类型、处理流程以及在实际应用中的重要性,帮助您更好地理解如何利用数据流优化数据处理和分析。

数据流指的是数据在系统之间的传输和处理过程。它涵盖了数据从产生、收集、传输、处理到存储的整个过程。数据流不仅涉及数据的移动,还包括数据在不同系统中的转化和应用。有效的数据流管理能够确保数据在各个环节之间高效、安全地流动,并为决策和分析提供准确的信息。

1. 实时数据流

实时数据流处理涉及实时收集和分析数据,以实现即时决策和反应。常见于金融交易监控、社交媒体分析和在线广告投放等场景。实时数据流需要高效的数据处理能力,以支持低延迟的数据传输和处理。

2. 批处理数据流

批处理数据流指的是定期处理大量数据的过程,通常在一定的时间间隔内进行。适用于数据分析、数据仓库更新和大规模报告生成等任务。批处理方式可以更好地处理复杂的数据转换和汇总任务,但通常会有一定的延迟。

3. 增量数据流

增量数据流处理关注数据的变化部分,即只处理自上次处理以来发生变化的数据。这种方式可以减少数据处理的量,优化处理效率,常用于增量备份和数据同步等应用。

4. 流式数据处理

流式数据处理指的是对数据流进行连续处理和分析的过程,支持对数据流的实时监控和即时反馈。适用于实时数据分析、传感器数据处理和物联网应用。

1. 数据收集

数据流的第一步是数据的收集。这可能包括从传感器、用户输入、日志文件、API等各种来源获取数据。数据收集过程需要确保数据的完整性和准确性。

2. 数据传输

数据在系统之间的传输需要通过高效、安全的通道。数据传输可以通过消息队列、流处理平台、API等方式进行。确保数据传输过程中的低延迟和高可靠性是关键。

3. 数据处理

数据处理包括数据的清洗、转换、分析等步骤。数据处理的目标是将原始数据转换为有价值的信息,以便进一步分析和决策。常用的技术包括ETL(抽取、转换、加载)、流处理框架(如Apache Kafka、Apache Flink)和数据湖等。

4. 数据存储

数据处理后的结果需要存储在合适的存储介质中,如数据库、数据仓库、数据湖等。数据存储解决方案需要支持高效的查询和数据访问,确保数据的持久性和安全性。

5. 数据可视化与分析

数据可视化和分析是数据流的最终阶段,通过图表、报告、仪表盘等形式呈现数据,以支持决策和业务洞察。有效的数据可视化可以帮助用户更直观地理解数据,并做出明智的决策。

1. 实时决策支持

通过实时数据流,企业能够快速响应市场变化和业务需求。例如,金融行业通过实时数据流监控交易活动,及时检测异常行为并采取措施,减少风险损失。

2. 提升业务效率

增量数据流处理可以减少数据处理的负担,提升系统性能。例如,电商平台通过增量同步技术优化库存管理和订单处理,提高业务操作效率。

3. 改进用户体验

实时数据流可以支持个性化服务和实时反馈,提升用户体验。例如,社交媒体平台通过实时数据分析推送相关内容和广告,提高用户参与度和满意度。

4. 数据驱动的决策

数据流的有效管理可以提供准确的数据支持,帮助企业做出数据驱动的决策。例如,营销部门通过分析用户行为数据优化广告策略,实现更好的市场定位和资源配置。

以流媒体平台为例,平台通过实时数据流处理用户观看行为、推荐内容和广告投放。实时分析用户行为数据,能够动态调整推荐算法,提升用户的观看体验和平台的收入。

在制造业中,通过传感器数据流实时监控设备状态,进行故障预测和预防维护。实时数据流分析帮助减少停机时间,提高生产效率,并降低维护成本。

数据流在现代数据处理和分析中扮演着关键角色。从数据的收集、传输、处理到存储和分析,每一步都是确保数据高效、准确流动的关键环节。通过有效的数据流管理,企业能够实现实时决策、提升业务效率、改进用户体验,并支持数据驱动的决策。随着数据量和复杂性的增加,理解和优化数据流将变得愈加重要,为企业的数字化转型和创新发展提供强有力的支持。

实时数据集成架构设计是构建弹性和可扩展的数据流处理系统的基础。通过考虑容错性、自动化伸缩、异步处理、无状态设计等原则,您可以建立一个能够应对快速变化数据的强大系统。FineDataLink作为一个成功的实践案例,为您提供了一个可行的选择,帮助您构建高效、弹性和可扩展的实时数据流处理系统,为企业的决策和创新提供强有力的支持。

数据集成平台产品更多介绍:www.finedatalink.com

上一篇: API对接:数字化时代的关键技术与实践指南下一篇: 什么是流批一体?怎样理解流批一体?