作者:finedatalink

发布时间:2023.8.4

阅读次数:379 次浏览

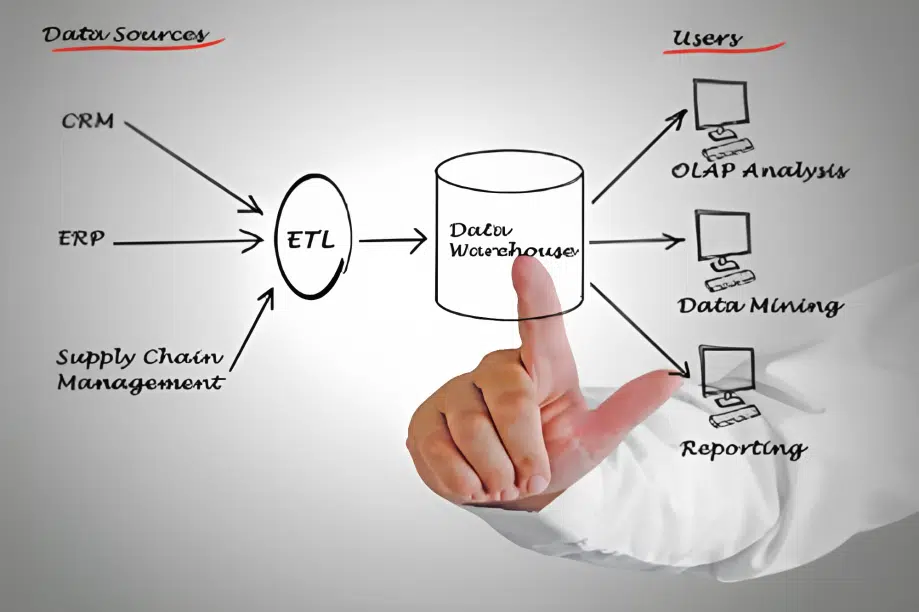

作为大数据处理中的重要环节,ETL技术在数据流程建模和优化方面起到关键作用。本文将重点介绍一些在ETL技术中的数据流程建模和优化技巧,帮助读者更好地应用ETL技术处理大数据。

在进行数据流程建模时,需要了解业务需求和数据来源,根据数据类型和数据质量要求,设计合理的数据流程模型。建立完整的数据模型,既要考虑数据的传输和转换过程,也要考虑数据的存储和查询方式。此外,需要合理设计数据流程中的阶段和任务,确保数据能够按照预期流动,提高数据处理的效率和准确性。

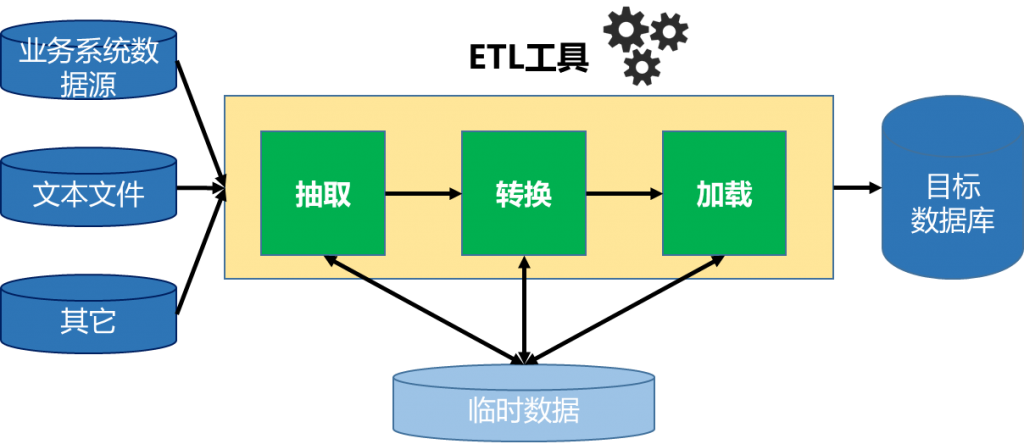

在ETL技术中,数据流一般分为抽取(Extraction)、转换(Transformation)和加载(Loading)三个阶段。在数据流程建模时,应该明确每个阶段的数据流向和关系,确保数据能够正确地经过每个阶段,并在加载时被正确处理。

例如,在抽取阶段中,可以使用增量抽取方式减少数据抽取量,提高数据抽取速度。

在转换阶段中,可以通过数据清洗、数据合并和数据转换等技术处理数据,提高数据质量和准确性。

在加载阶段中,可以使用批量加载或分批加载方式,提高数据加载效率。

在数据流程建模和运行过程中,可以通过一些技巧来优化数据处理的效率。

一方面,可以优化数据的抽取和加载过程,例如使用并行处理技术提高数据的读取和写入速度,使用压缩技术减少数据存储空间。

另一方面,可以优化数据转换和处理过程,例如使用内存计算技术加快数据转换速度,使用索引技术提高数据查询速度。

此外,还可以通过合理调整ETL任务的调度和执行策略,减少资源的占用和冗余操作,提高整个数据流程的效率。

总结起来,ETL技术中的数据流程建模和优化技巧对于处理大数据具有重要意义。通过合理的数据流程建模,可以更好地满足业务需求;通过优化技巧,可以提高数据处理的效率和准确性。在应用ETL技术过程中,读者可以参考本文提到的技巧,灵活运用,以提高大数据处理的效率和质量。

FineDataLink是国内做的比较好的ETL工具,FineDataLink是一站式的数据处理平台,拥有低代码优势,通过简单的拖拽交互就能实现ETL全流程,具备高效的数据同步功能,可以实现实时数据传输、数据调度、数据治理等各类复杂组合场景的能力,提供数据汇聚、研发、治理等功能。

数据集成平台产品更多介绍:www.finedatalink.com