作者:finedatalink

发布时间:2023.7.28

阅读次数:388 次浏览

数据集成和ETL(提取、转换和加载)是数据处理中重要的环节。虽然它们有着相似的目标,但在实际应用中存在一些区别与联系。本文将从以下几个方面进行详细解析,帮助读者更好地理解数据集成与ETL。

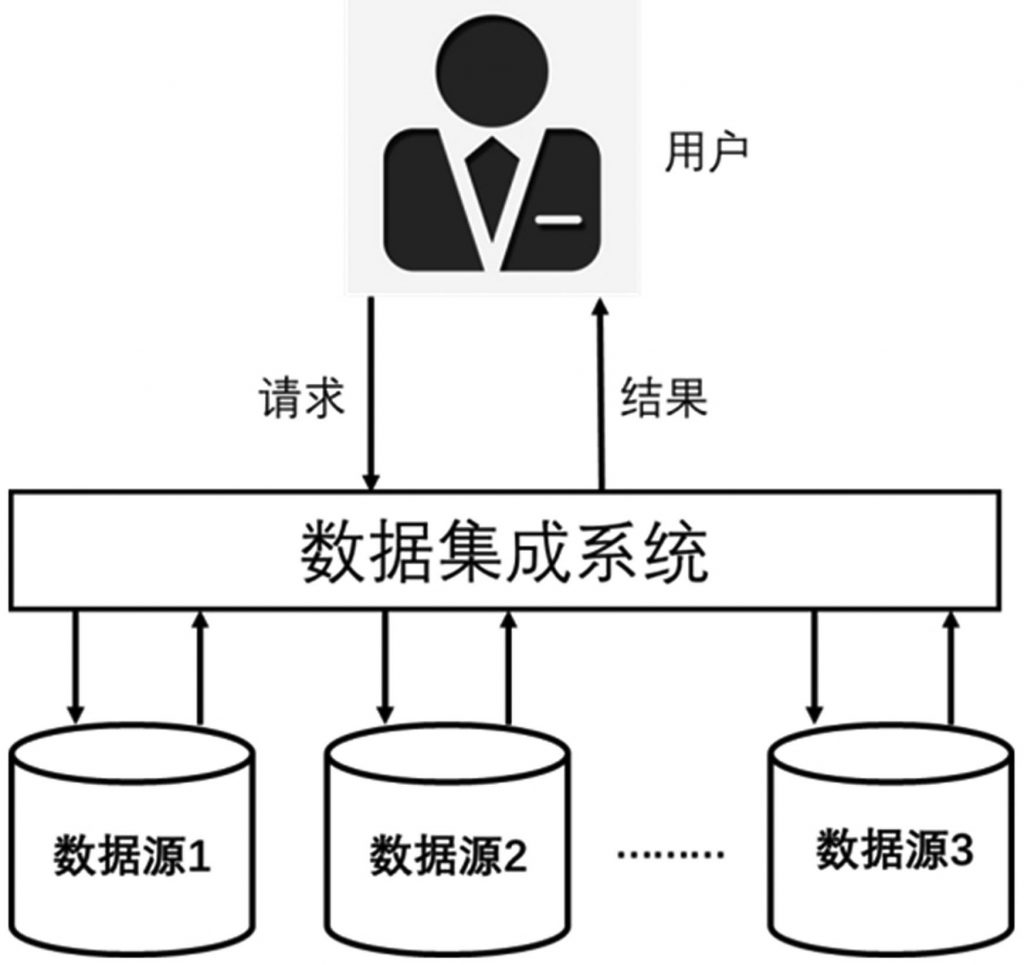

数据集成是将来自不同数据源的数据统一到一个集中的存储位置中,方便数据的管理和分析。

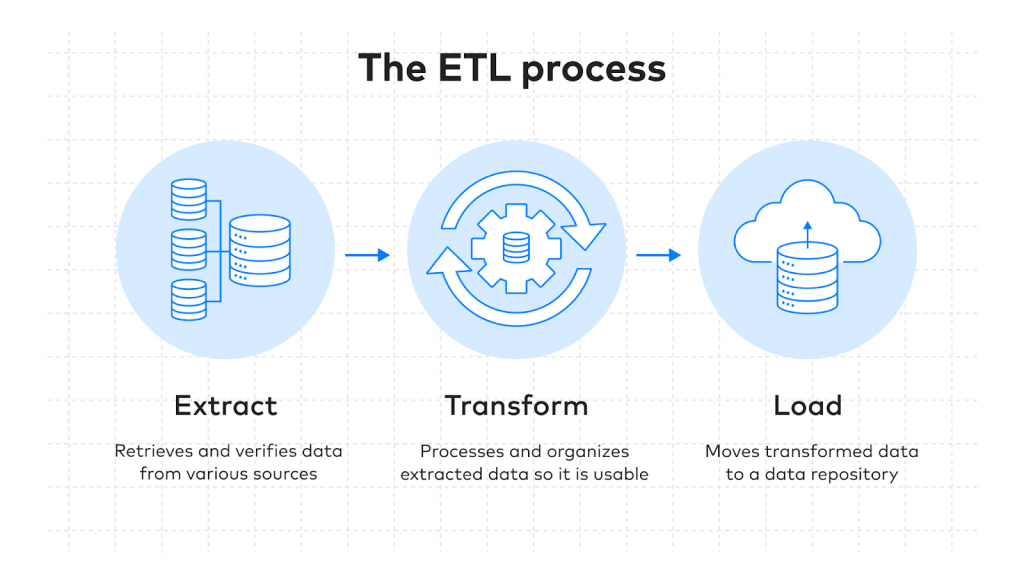

ETL指的是将数据从源系统中提取出来,经过一系列的转换和清洗操作后,加载到目标系统中。

数据集成旨在解决数据来源分散、格式不一致、冗余数据等问题,构建统一的数据平台,方便后续的数据处理和分析。

ETL更加细化,包括提取(Extraction)、转换(Transformation)和加载(Loading)三个步骤,完成从原始数据到目标数据的全过程。

数据集成包括数据源识别、数据采集、数据清洗和数据存储等几个步骤,过程相对简单直接。

ETL的流程复杂,包括数据提取、数据规整、数据转换、数据清洗和数据加载等多个步骤,需要对数据进行多次转换和操作。

数据集成主要用于构建数据仓库、数据湖等数据存储系统,提供数据给企业的决策分析、报表和可视化等应用。

ETL除了数据整合的应用场景外,还可用于数据迁移、数据备份和数据同步等需求。

综上所述,虽然数据集成与ETL之间存在一些区别和联系,但二者又是密不可分的。数据集成是ETL的一个重要环节,共同完成了数据从来源到目标的处理过程。无论是数据集成还是ETL,它们都是数据处理和分析的基础。希望通过本文的解析,读者对数据集成和ETL有了更加深入的了解。

FineDataLink是国内做的比较好的ETL工具。FineDataLink是一站式的数据处理平台,拥有低代码优势,通过简单的拖拽交互就能实现ETL全流程。具备高效的数据同步功能,可以实现实时数据传输、数据调度、数据治理等各类复杂组合场景的能力,提供数据汇聚、研发、治理等功能。

数据集成平台产品更多介绍:www.finedatalink.com