作者:finedatalink

发布时间:2023.8.8

阅读次数:415 次浏览

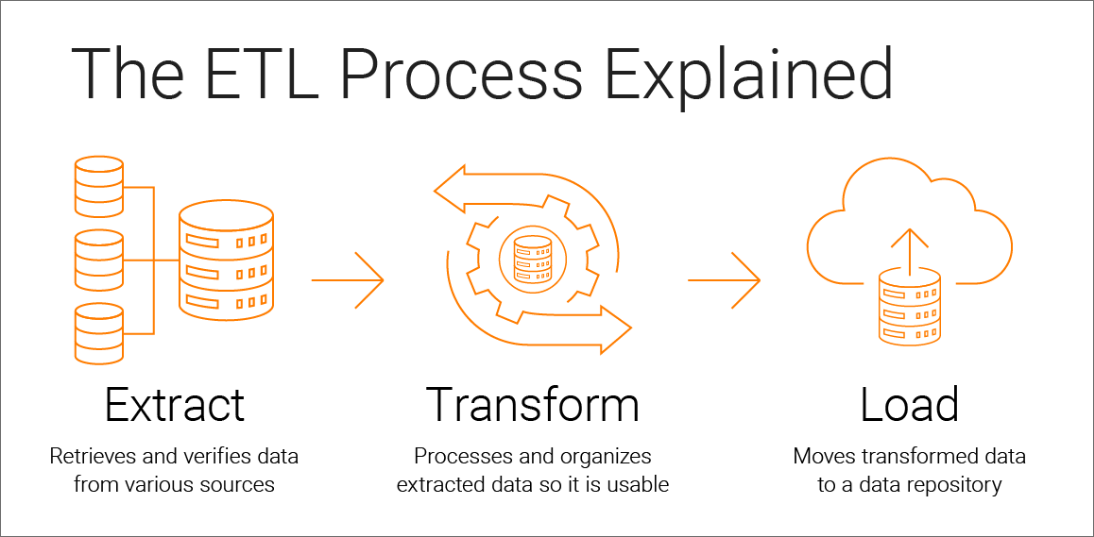

在数据处理工作中,ETL(Extract-Transform-Load)过程扮演着关键的角色,它负责从不同数据源中提取数据,经过转换和加工后加载到目标系统中。然而,ETL过程在实际应用中可能会面临一系列挑战,包括作业失败、部分成功以及数据质量问题。为了确保ETL过程的容错性和稳定性,我们需要深入探讨以下几个方面的优化措施:

在ETL过程中,异常和故障是难以避免的。为了保障容错性,应实施完善的异常处理和故障恢复机制。首先,建议在代码中使用适当的异常捕获和处理,确保出现问题时,程序可以妥善处理而不会崩溃。其次,对于重要的数据处理任务,可以将其划分为较小的子任务,每个子任务都具备独立的异常处理逻辑,这样可以降低出错时的影响范围,并有助于故障恢复。最后,考虑实施作业状态监控和日志记录,及时发现并排查潜在问题,为故障排查提供线索。

在ETL过程中,数据质量是至关重要的,因为低质量的数据可能导致错误的决策和分析结果。为了确保数据质量,推荐引入数据质量检查和校验机制。在数据提取阶段,可以验证源数据的完整性、准确性和一致性。在数据转换和处理阶段,可以实施规则验证和数据清洗,修复或剔除不符合规范的数据。另外,建议在数据加载前后进行数据质量评估和监控,确保数据在整个ETL过程中保持高质量。

为确保数据处理的一致性,对于需要跨多个步骤或多个数据源的复杂作业,建议引入事务管理机制。通过将相关操作放入事务中,并且遵循ACID特性,可以确保数据在处理过程中的原子性、一致性、隔离性和持久性。当出现错误或失败时,事务会自动回滚,将所有已完成的操作撤销,保持数据的一致性,避免数据损坏和不一致。

为了进一步提高ETL过程的容错性,推荐定期进行容错性测试。通过模拟异常情况和故障,测试ETL过程的反应和恢复能力,发现并解决潜在的问题。在测试中,可以模拟网络中断、源数据丢失、转换错误等情况。在发现问题后,及时优化代码和流程,增强系统的容错性和稳定性。

ETL过程通常会长时间运行,因此建议实施实时监控和报警系统。监控可以检测作业的运行状态、性能指标以及数据流向,帮助快速发现异常和瓶颈。当作业失败或出现异常时,报警系统能够及时通知相关人员,使其能够迅速响应并采取必要的措施。

自动化重试是处理临时错误的有效方法,例如暂时的网络波动或系统负载过高。通过在失败时自动重试作业,可以在问题解决后自动恢复作业的执行。此外,在设计ETL过程时,考虑采用幂等性设计,即使在多次执行时,数据结果也是一致的。这样即使重试发生,不会对数据产生重复或冲突。

ETL过程中的数据通常来自多个数据源,因此建议采取容灾和备份措施。对于关键数据源,确保其具有高可用性和冗余,以防止单点故障。同时,定期对数据进行备份,以便在数据丢失或损坏时可以快速恢复数据。备份数据还可以提供数据历史记录,用于追溯和分析数据处理的过程和结果。

综上所述,ETL过程在数据处理中起到了至关重要的作用。为了确保其容错性和稳定性,我们应考虑异常处理和故障恢复、数据质量保障、事务管理与回滚、容错性测试和优化、实时监控和报警、自动化重试与幂等性设计,以及容灾与备份等方面的优化措施。

FineDataLink作为低代码/高时效的ETL数据集成平台,通过精心规划和实施这些措施,能够更好地满足用户的需求,提供稳定可靠的数据处理服务,帮助企业充分发掘数据价值,推动业务发展。

数据集成平台产品更多介绍:www.finedatalink.com

上一篇: 数据清洗:数据集成成功的关键抉择下一篇: 帮你选ETL架构:批量、增量还是实时流式,哪种适合你的数据处理需求?