作者:finedatalink

发布时间:2023.8.10

阅读次数:320 次浏览

在当今信息时代,数据处理的高性能和稳定性是企业不可或缺的关键。本文将深入探讨高性能数据集成的核心技术,突出异步/并发读写机制的优势,以及构建稳固的数据处理基石的重要性。

高性能数据集成不仅仅追求速度,更在于实现更高效、更实时的数据处理。利用先进的计算引擎,如Spark,能够极大地提升数据处理速度,同时通过并发处理实现数据的快速流动。这种高性能数据集成方式,能够为企业的业务流程注入新的活力。

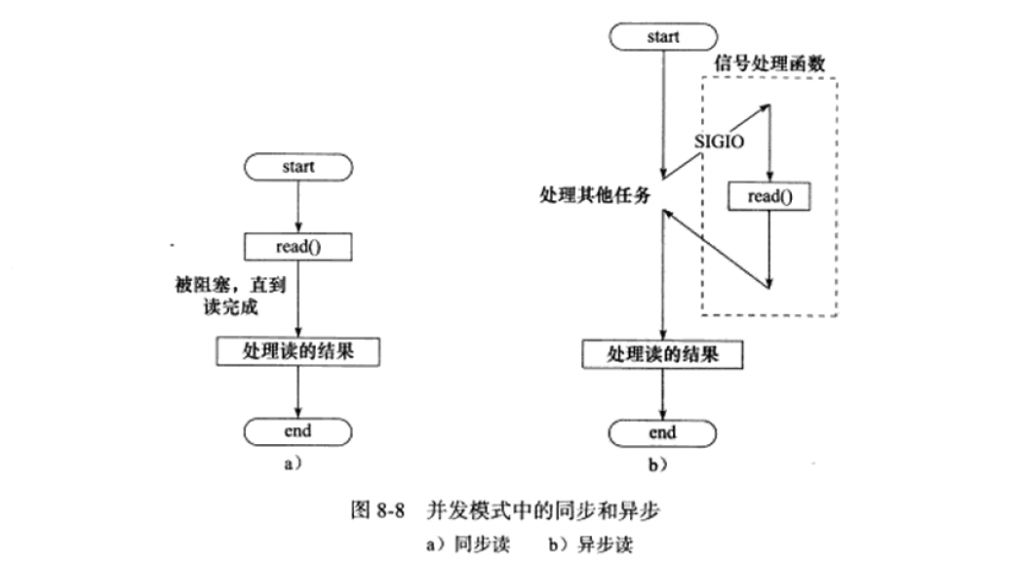

异步/并发读写机制的引入,极大地优化了数据同步流程。通过将数据读取和写入操作并行进行,不仅能够缩短数据处理的时间,还能够实现实时数据传输,为业务决策提供准确支持。这种机制使数据同步不再成为瓶颈,提升了数据集成质量。

构建稳固的数据处理基石是实现高性能和稳定性的关键。采用高可用/高并发集群架构,可以在高负载情况下保持系统的稳定运行。同时,自动化调优技术的应用,使系统能够根据实际情况动态调整资源分配,确保数据处理的连续性和稳定性。这种基石为企业的数据处理提供了坚实支撑。

高性能数据集成不仅仅是技术层面的优化,更关系到企业的商业价值。流畅的数据处理流程能够使企业更快地做出决策,捕捉商机,提升竞争力。而稳定的数据处理基石,则是保障业务连续运营的关键。在信息时代,高性能数据集成将为企业开启更多商机之门。

本文详细探讨了高性能数据集成的核心,从高性能数据集成的实质、异步/并发读写机制的优势,到构建稳固的数据处理基石的重要性。这些技术方法不仅提升了数据集成质量,也为企业的业务创造了更多商业价值。FineDataLink是国内做的比较好的ETL工具,具备高效的数据同步功能,可以实现实时数据传输、数据调度、数据治理等各类复杂组合场景的能力,提供数据汇聚、研发、治理等功能。

数据集成平台产品更多介绍:www.finedatalink.com