作者:finedatalink

发布时间:2023.8.7

阅读次数:1,784 次浏览

数据仓库ETL在现代化企业中扮演着重要的角色,但是ETL工具也可以单独使用。接下来将为大家介绍一些常用的ETL工具,并进行详细分析。

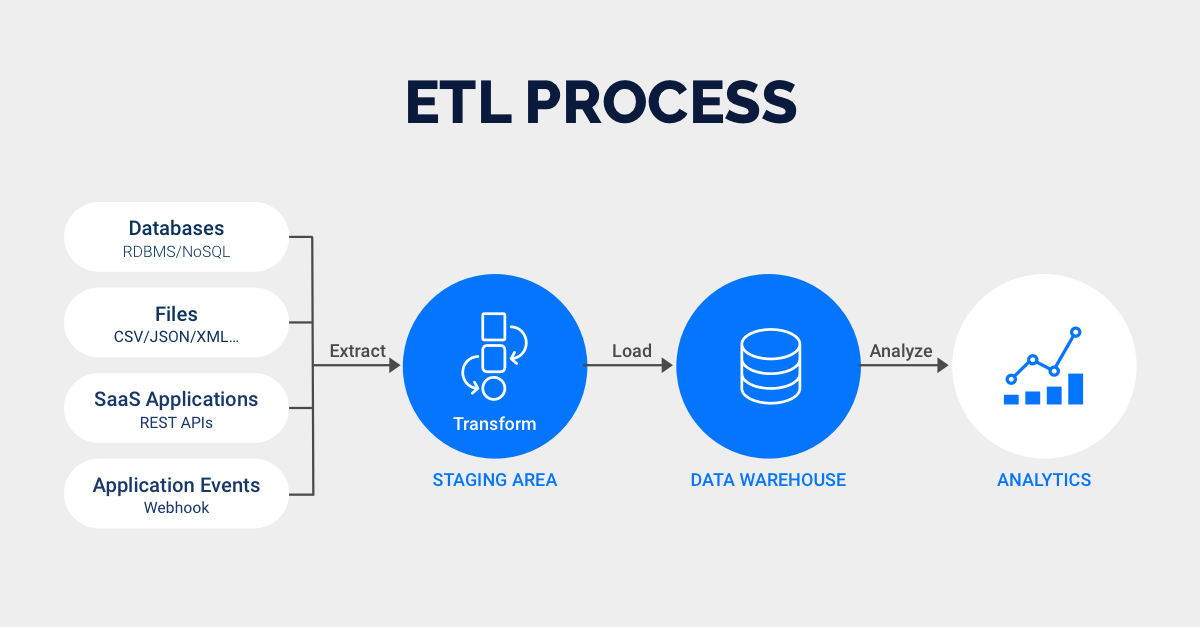

数据仓库ETL流程

IBM WebSphere DataStage是一款用于数据抽取、转换和维护的数据集成工具,可自动化处理多种操作数据源的过程,并将其输出到数据集市或目标数据库中。DataStage具有以下功能:

1、DataStage可以从不同平台和业务系统中抽取数据,进行转换和清洗。

2、DataStage支持增量抽取、任务调度等多个功能,同时还提供调试工具以提高开发和调试效率。

3、Datastage可独立管理元数据,而且可以为每个任务设置参数,支持Job内部引用构建好的参数名。

4、Datastage提供用于保障数据质量的插件ProfileStage和QualityStage。用户还可以编写批处理程序,实现抽取和转换功能的定制化开发。

5、Datastage使用图形化界面,提供Administrator、Manager、Designer和Director四大部分,可实现项目的设置、Job的设计、Job的运行监控和备份以及任务管理等多种功能。

Datastage 操作界面

Informatica PowerCenter是用于访问和集成各种业务系统和数据格式的可视化数据集成工具。Informatica具有以下功能:

1、参数控制方面:Informatica将参数放在一个参数文件中,理论上可以灵活控制参数,但需要用户手动更新参数值(例如日期更新),同时不能在mapping或session中引用参数名。

· 数据质量方面:Informatica公司提供了专门的Informatica Data Quality用于保证数据质量。定制开发方面,PowerCenter没有内嵌类BASIC语言,且参数值需要手动更新,也不能引用参数名。

· 数据转换方面:Informatica可使用近20种数据转换组件和近百个可调用的函数,还可以调用外部过程和程序,以实现复杂转换逻辑。

4、修改维护方面:Informatica与Datastage相同,提供了图形化界面,简单直观,但对于大批量的修改仍需面对一定的挑战。

Informatica 操作界面

Pentaho Data Integration,也称Kettle,是一种开源、免费的、可视化的ETL工具。Kettle提供了丰富的组件,主要包括脚本组件、映射组件、统计组件、连接组件、查询组件、流程组件、应用组件、转换组件、输出组件和输入组件。Kettle有以下六个特点:

1. 免费开源:它是基于Java的免费开源软件。

2. 易于配置:Kettle可以跨平台运行,不需要安装。

3. 适用于不同数据库:作为数据仓库ETL工具,它可以管理不同数据库的数据。

4. 两种脚本文件:Kettle提供了两种脚本文件,分别是transformation和job。

5. 图形界面设计:Kettle采用简单易用的拖拽方式,无需编写代码。

6. 定时功能:在job的开始模块下,可以按日、周等时间定时进行任务的运行,但必须一直启动kettle界面。一旦界面被关闭,就无法保证任务的定时运行。所以一般通过脚本+windows的定时任务来保证正常运行。

Kettle的执行分为两个层次:Job和Transformation。这两个层次的最主要区别在于数据的传递和运行方式。

1、Transformation是一个用于定义数据操作容器的概念,可以看作是比Job的粒度更小的容器。每个Transformation用于完成一部分工作,并由多个Step组成,每个Step完成一项特定的功能。

2、Job负责组织Transformation以完成特定任务,并且可以将多个Job组合在一起。Job中包含多个Job Entry,每个Job Entry用于实现特定的功能,如验证表是否存在或发送邮件等。Job Entry可以是Transformation或者另一个Job。Hop用于在Transformation中连接Step或在Job中连接Job Entry,是数据流的图形化表示。

Kettle 操作界面

帆软推出的FineDataLink是一款低代码/高时效的ETL工具,功能包括以下:

1. 数据整合:FineDataLink支持三十多种数据源和格式,可以轻松地进行数据整合,包括关系型数据库、文件、Web服务等。

2. 自动化数据映射:FineDataLink的数据映射功能可以自动将数据源中的数据映射到目标数据库表中,大大简化数据转换的流程。

3. 数据质量:通过预定义的规则和算法,FineDataLink能够帮助确保数据的准确性、一致性和完整性。

4. 操作简便:FineDataLink使用简单直观的图形化界面,让用户可以轻松创建ETL任务,无需编写复杂的代码。

5. 高性能和高可靠性:FineDataLink使用高效的ETL算法和架构,可以处理大规模的数据集,同时保证数据的安全性和可靠性。

6. 报告和监控:FineDataLink提供了详细的报告和监控功能,让用户能够快速地获取ETL任务的运行情况和性能数据。

FineDataLink操作界面

Oracle Data Integrator(ODI)是Oracle公司提供的一种ETL工具,也是一个数据集成工具,支持集成大多数关系型数据库,如Oracle、DB2、SQL Server、MySQL和SyBase等。

ODI提供图形化客户端和Agent运行程序。客户端软件主要用于整个数据集成服务的设计,包括创建数据源的连接、创建模型及反向表结构、创建接口、生成方案和计划等。Agent运行程序通过命令行方式在ODI服务器上启动的服务,周期性地执行Agent下的执行计划。

ODI的常见应用场景包括数据仓库ETL阶段、数据迁移、数据集成和数据复制等。

ODL操作界面

SAP Data Services是一种企业级数据整合工具,能够提高企业的数据质量,其包含了强大的数据整合、数据质量管理和数据清理功能。

SAP Data Services具有以下主要功能:

1. 数据整合:支持连接多个不同数据源,诸如数据库、文件、Web服务等,并提供了强大的ETL功能,轻松地将数据从一个地方移动到另一个地方。

2. 数据质量管理:提供丰富的数据质量规则和算法,帮助保证数据的准确性、数据一致性和完整性,并支持数据清理、去重、标准化等。

3. 数据清理:支持文本、电话、地址等各种数据类型的清洗,并具有数据重复性检测、缺失值填充、数据去噪和数据标准化等强大功能。

4. 实时数据集成:通过实时数据采集、数据转换和数据传输,从不同数据源和实时数据流中提取数据,并将其转化为有用的信息。

DS操作界面

在传统数仓时代,DataStage、Informatica占据了大部分市场份额,Kettle也在中小型数据仓库ETL应用场景中广泛应用。这些传统ETL工具虽然在过去取得了很大的成就,但随着云计算、大数据等技术的发展,这些工具的不足也日益显现。例如,它们学习成本较高,而且需要编写大量的代码以完成复杂的数据转换和数据集成任务,开发效率低。其中一些不支持实时数据处理,难以满足实时数据处理的需求。

这也给新一代ETL工具的发展提供了机遇和空间。例如,FineDataLink数据平台的各个使用环节均采用拖拉拽式进行流程化数据开发,降低了产品使用门槛。除此之外,FineDataLink具有数据管道功能,可以进行数据实时同步,为数据的高时效输出使用提供了保障。

数据集成平台产品更多介绍:www.finedatalink.com