作者:finedatalink

发布时间:2023.7.26

阅读次数:286 次浏览

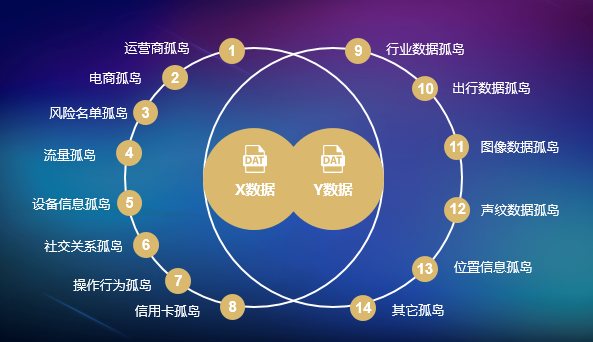

在当今数字化时代,企业面临着日益增长的数据量和数据来源多样性的挑战。数据孤岛问题指的是数据被存储在各种独立系统中,无法有效地进行整合和共享的情况。解决数据孤岛问题,有助于企业快速部署数据集成方案并验证其效果。

本文将分享一些实践经验,帮助企业最大限度地减少数据集成的时间,实现快速部署和效果验证。

要解决数据孤岛问题,需要一个强大且易于使用的数据集成平台。这个平台应具备灵活的数据处理能力,能够连接各种数据源,并提供直观易懂的界面进行配置和操作。同时,平台应支持自动化任务调度和监控,以提高集成效率和可靠性。

快速部署和效果验证需要有清晰的项目规划和明确的目标。在项目启动前,应明确数据集成的目标和需求,并制定详细的实施计划。这包括确定数据集成的优先级和时间安排等。同时,应与相关部门和团队进行充分的沟通和合作,确保能够快速获取所需的数据。

采用数据预处理和清洗技术,可以显著提高数据集成的效率和准确性。数据预处理包括数据抽取、转换和加载等过程,可以对数据进行规范化和标准化,以便于后续的整合和分析。清洗数据意味着去除无效和冗余数据,以提高数据质量和准确性。

采用自动化工具和技术,可以加快数据集成的速度和效果验证的进程。自动化工具可以通过自动化任务调度和执行,减少人工干预和处理的时间。同时,自动化技术还可以提供实时监控和报警,及时发现和解决集成过程中的问题。

数据安全和隐私保护是快速部署和效果验证过程中应重视的问题。在数据集成过程中,需要确保数据的安全传输和存储,并遵守相关的隐私保护法规和政策。采用加密技术和访问控制机制,可以有效保护数据的安全和隐私。

快速部署和效果验证是一个迭代的过程。在初步完成数据集成和效果验证后,需要及时总结经验教训,并进行优化和改进。这样可以不断提高数据集成的效率和准确性,并实现快速部署和效果验证的目标。

总之,解决数据孤岛问题需要一系列的步骤和最佳实践。通过选择合适的数据集成平台,制定明确的项目规划和目标,利用数据预处理和清洗技术,采用自动化工具和技术,保证数据的安全和隐私,并进行持续的优化和改进,企业可以最大限度地减少数据集成的时间,实现快速部署和效果验证。这将为企业提供快速决策和创新的能力,增强竞争力,促进业务发展。

FineDataLink 是一款低代码/高时效的ETL数据集成平台,面向用户大数据场景下,满足实时和离线数据采集、集成、管理的诉求,提供快速连接、高时效融合各种数据、灵活进行ETL数据开发的能力,帮助企业打破数据孤岛,大幅激活企业业务潜能,使数据成为生产力。

数据集成平台产品更多介绍:www.finedatalink.com

上一篇: 干货满满!数据孤岛威胁企业生存?下一篇: 学到了!数据集成解决方案这样开展